Jak unikać duplikacji treści w e‑commerce i chronić widoczność sklepu online

Duplikacja treści w e‑commerce: cichy hamulec Twojego sklepu

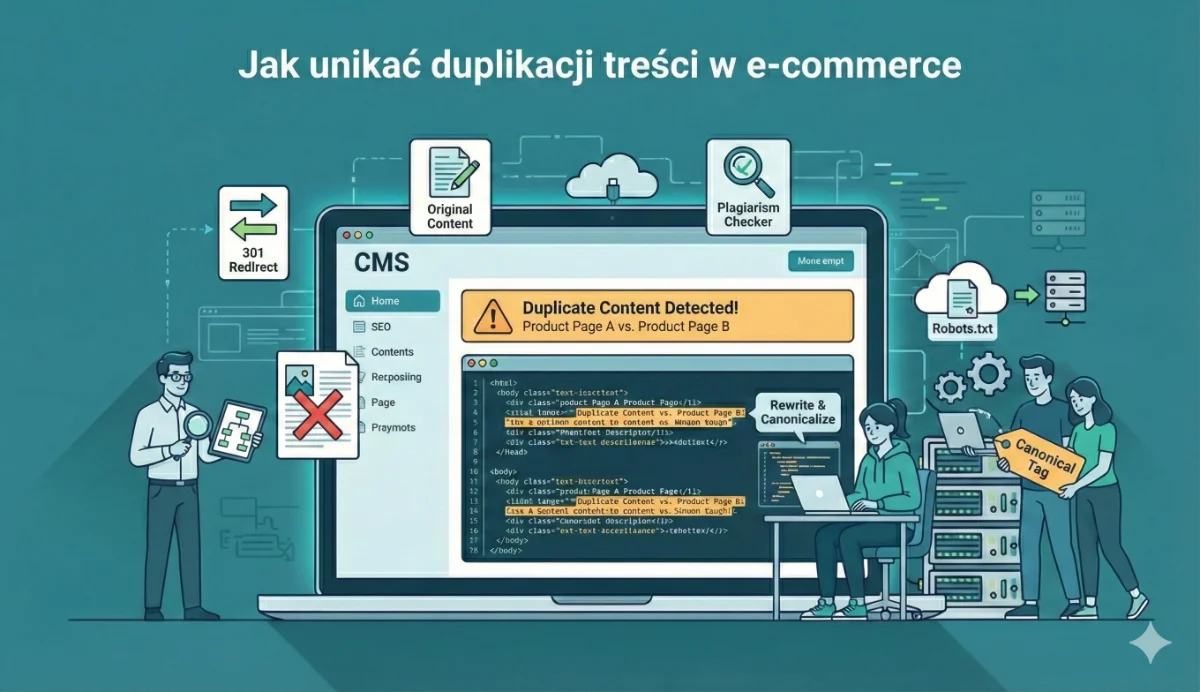

W wielu audytach, które prowadziłem, scenariusz wyglądał podobnie: marketing robi kampanie, budżet na reklamy rośnie, a SEO stoi w miejscu. Po kilku godzinach w logach serwera i narzędziach crawlingowych wychodzi na jaw, że 15–30% całego serwisu to kopie lub prawie kopie istniejących stron. Sklep sam ze sobą walczy w Google.

Duplikacja treści w e‑commerce to nie „techniczny szczegół”. To realny hamulec rozwoju, który potrafi zjeść sporą część potencjału ruchu organicznego – i to zupełnie po cichu.

Co Google naprawdę robi z duplicate content w sklepach

W skrócie: nie chodzi o to, że „Google nienawidzi duplikacji”. Problem jest inny – algorytm musi zgadnąć, którą wersję strony uznać za główną.

Duplikacja treści to każda sytuacja, w której ten sam lub bardzo podobny tekst jest dostępny pod kilkoma adresami URL. Może się to dziać:

- wewnątrz Twojego sklepu (wewnętrzna duplikacja),

- między Twoim sklepem a innymi domenami (zewnętrzna duplikacja).

Do tego nie wystarczy zmienić meta title czy description. Robot patrzy przede wszystkim na realny, widoczny opis – to, co czyta użytkownik. Jeśli treść na stronie A i stronie B jest niemal identyczna, drobne różnice w nagłówku niczego nie zmieniają.

W praktyce Google rzadko nakłada ręczne kary tylko za duplikację. Zamiast tego filtruje kopie, wybiera jedną wersję jako kanoniczną, a resztę „przycisza” w wynikach. Efekt dla Ciebie jest prosty: część podstron praktycznie przestaje mieć szansę na ruch, a autorytet domeny rozlewa się po wielu adresach.

Zupełnie inaczej działa to przy różnych wersjach językowych. Jeśli każda z nich ma swój URL, sensowne tłumaczenie (a nie automatyczną kalka) i poprawnie ustawiony hreflang – Google traktuje je jako warianty językowe, a nie duplicate content.

Na blogu czy w sekcji poradnikowej pojawia się jeszcze jeden problem – kanibalizacja. Kilka podobnych artykułów o tym samym temacie zaczyna rywalizować o te same frazy. Zdarzało mi się widzieć blogi, gdzie pięć tekstów „jak dobrać rozmiar butów” nawzajem sobie podcinało pozycje.

Zewnętrzna vs wewnętrzna duplikacja: dwa różne problemy

W e‑commerce zwykle walczymy na dwóch frontach.

Zewnętrzna duplikacja – gdy Twój opis nie jest „Twój”

Najbardziej oczywisty przypadek: kopiowanie opisów producenta. Ten sam tekst trafia do kilkudziesięciu czy kilkuset sklepów. Google musi wybrać jeden wynik – bardzo często będzie to największy serwis z najwyższym autorytetem, a nie ten, który ma najlepszą ofertę.

Do tego dochodzi nowa plaga ostatnich lat: hurtowo generowane przez AI, niemal identyczne opisy, oparte na tych samych promptach i szablonach. Z zewnątrz wyglądają różnie, ale z perspektywy algorytmu często są po prostu kolejną wariacją tej samej treści.

Ciekawy, a mało omawiany problem pojawia się przy afiliacji i syndykacji. Zdarzyło mi się widzieć sytuację, w której to nie sklep, tylko duży portal afiliacyjny z kopią opisów stał się dla Google „oryginałem”. Sklep, który tę treść stworzył, wyglądał w wynikach jak kopia partnera.

Podobnie działają feedy RSS, porównywarki cen i marketplace’y. Gdy wysyłasz do nich pełne opisy produktów 1:1, sam tworzysz sobie zewnętrzną duplikację – szczególnie niebezpieczną, jeśli te serwisy mają większy autorytet niż Twój sklep.

Wewnętrzna duplikacja – czyli własny serwis jako konkurencja

Drugi, często większy front to duplikacja wewnętrzna. Zazwyczaj nie wynika ze złej woli, tylko z rozbudowanej struktury sklepu i „przyjaznych” funkcji dla użytkownika.

Najczęstsze źródła, które regularnie widzę w audytach:

- Strony kategorii + filtry + sortowanie. Kombinacje filtrów potrafią tworzyć setki czy tysiące adresów z niemal identyczną listą produktów i tym samym opisem kategorii. Dla klienta to wygodne. Dla Google – setki thin duplicate pages.

- Parametry URL. Zmiana sortowania, widoku (lista / kafelki), paginacja, waluta, parametry sesji – wszystko to może generować nowe URL z tą samą treścią. Jeśli ich nie ogarniesz canonicalem lub noindexem, część z nich wyląduje w indeksie.

- Warianty produktów na osobnych podstronach. Ten sam model w 10 kolorach, każdy jako osobna karta produktu z niemal identycznym opisem – klasyczny przepis na wewnętrzny duplicate content.

- Kilka wersji tej samej strony. HTTP i HTTPS, z www i bez, wersja mobilna na subdomenie, testowe środowiska typu stage.domena.pl lub dev.domena.pl dostępne z zewnątrz. Widziałem sklepy, gdzie staging z całą kopią treści spokojnie indeksował się obok produkcji.

- Archiwa, promocje, nowości, bestsellery. Te sekcje często używają tego samego opisu co główna kategoria, a do tego powielają listę produktów. Rezultat: równoległe adresy z tą samą treścią.

- Strona główna vs kategorie. Bardzo częsty, subtelny case: krótki opis kategorii skopiowany jako „sekcja SEO” na stronie głównej. Google musi zgadnąć, co jest ważniejsze – home czy kategoria.

- Koszyk, checkout, lista życzeń. Jeśli te strony są indeksowane, zawierają fragmenty opisów produktów i generują dodatkową pulę powtarzającego się tekstu w obrębie domeny.

- Recenzje klientów. Często widzę ten sam zestaw opinii zarówno na karcie produktu, jak i na osobnych podstronach typu /opinie lub /product/opinie. W efekcie rozmywają się sygnały rankingowe, a CTR z SERP nie rośnie tak, jak mógłby.

Raz, przy audycie średniego sklepu, zobaczyłem w GSC dwie domeny z niemal identyczną liczbą zaindeksowanych stron. Okazało się, że… Google lepiej zaindeksował staging niż wersję produkcyjną. Wszystko dlatego, że nikt nie zablokował testowego środowiska przed robotami.

Jak duplikacja treści uderza w SEO i sprzedaż

SEO‑owo mechanizm jest prosty: wiele podobnych stron konkuruje o te same frazy. Google zamiast wzmacniać jedną, dobrze dopasowaną podstronę, rozkłada ruch na kilka „średniaków”.

Po stronie wyników:

- pojawia się kanibalizacja słów kluczowych – Twoje własne strony konkurują ze sobą,

- autorytet linków (link equity) rozprasza się między wieloma adresami,

- kluczowe karty produktów i kategorie spadają w wynikach lub „tańczą” z dnia na dzień,

- część podstron praktycznie przestaje być widoczna, bo zostaje przefiltrowana jako duplikat.

Technicznie dochodzi do marnowania crawl budgetu. Zamiast szybko indeksować nowe produkty i ważne zmiany, robot krąży po podobnych kombinacjach filtrów, parametrach sortowania czy klonach kategorii. Kilkakrotnie widziałem pozornie paradoksalną sytuację: po wdrożeniu canonicali i noindex liczba indeksowanych URL spadała o połowę, a ruch organiczny rósł o kilkadziesiąt procent.

Na końcu zawsze stoi biznes. Mniej widoczności kluczowych kategorii = mniej wejść z Google = mniejsza sprzedaż. Do tego słabe, kopiowane opisy produktów powodują więcej pytań do supportu, więcej zwrotów i więcej błędnych decyzji zakupowych. Dobre, unikalne treści robią odwrotność: tłumaczą różnice między modelami, odpowiadają na obawy klienta, zmniejszają liczbę zwrotów i podnoszą konwersję.

Tabela poniżej dobrze podsumowuje różnicę między sklepem „zalanym duplikacją” a takim, w którym porządek techniczny i treściowy jest dowieziony:

| Obszar | Stan przy dużej duplikacji treści | Stan po ograniczeniu duplikacji (canonical, noindex, porządna architektura) |

|---|---|---|

| Udział zduplikowanych URL | Około 10–30% wszystkich adresów w średnich sklepach; w dużych serwisach z filtrami nawet dziesiątki tysięcy podobnych URL | Znaczne ograniczenie liczby wariantów; często spadek indeksowanych URL o 40–70% przy zachowaniu kluczowych stron |

| Wykorzystanie crawl budget | Robot marnuje zasoby na powtarzalne podstrony, wolniejsza indeksacja nowych produktów i zmian | Skupienie crawla na najważniejszych kategoriach i produktach, szybsze indeksowanie aktualizacji |

| Widoczność SEO i długi ogon | Rozmyty autorytet, kanibalizacja słów kluczowych, słaba ekspozycja na frazy z długiego ogona | Wzmocnienie widoczności kategorii, lepsze pozycje na szczegółowe zapytania i stabilniejsza obecność w wynikach |

| Wyniki biznesowe i UX | Spadek widoczności kluczowych kategorii, niższa sprzedaż, więcej zwrotów i pytań do supportu | Wzrost ruchu organicznego, wyższa konwersja, mniej zwrotów dzięki lepszemu doświadczeniu użytkownika |

| Strategia treści | Kopiowane opisy producenta, słaba rozpoznawalność marki, problem z analityką wielu wersji URL | Autorskie treści budujące autorytet, czytelniejsze dane i łatwiejsze decyzje biznesowe |

Unikalne treści jako realny wyróżnik, nie „wypełniacz”

Kiedy wchodzę do panelu sklepu i słyszę „opisów mamy dużo, bo wszystko skopiowaliśmy od producenta”, to wiem, że właśnie tam leży część niewykorzystanego potencjału.

Opis produktu to nie rubryka do odhaczenia. To narzędzie sprzedaży i sygnał dla Google, jaką wartość wnosi Twoja strona.

Najpierw dobrze jest zadać sobie kilka prostych pytań z perspektywy klienta:

Czy ten produkt rozwiąże mój problem? Czym różni się od konkurencyjnego modelu? Dla kogo jest najlepszy?

Dopiero pod to warto układać treść: łączyć suche parametry (wymiary, materiały, specyfikacje) z praktycznymi korzyściami („co mi to daje w codziennym użytkowaniu”). Taki opis jednocześnie lepiej konwertuje i łapie długi ogon: konkretne, rozbudowane zapytania typu „buty trekkingowe na szeroką stopę na zimę” zamiast ogólnego „buty trekkingowe”.

Podobnie jest ze stronami kategorii. Zamiast krótkiego, sztampowego tekstu o tym, że „w naszej ofercie znajdziesz szeroką gamę…” lepiej napisać wprowadzenie, które faktycznie pomaga w wyborze: czym różnią się podkategorie, jakie parametry są kluczowe, na co uważać. Sklepy, które tak robią, mają potem całkiem ładne wykresy widoczności na frazy z długiego ogona.

Przy setkach czy tysiącach produktów kluczowe jest zarządzanie priorytetami. Zazwyczaj zaczynamy od:

- najważniejszych kategorii,

- bestsellerów i produktów z najwyższą marżą,

- pozycji, które realnie dowożą obrót.

Dopiero potem schodzimy głębiej w ogon oferty.

⚡ PRO TIP:

Zanim ruszysz z hurtową produkcją treści, przygotuj prosty, powtarzalny brief dla copywriterów: jaki jest cel strony, jaki zakres informacji musi się pojawić (cechy, korzyści, FAQ, porównania), jakich fraz używamy, czego unikamy (marketingowe wodolejstwo, kopiowanie z innych kart). To oszczędza tygodnie poprawek.

A co z AI?

AI świetnie przyspiesza pracę, ale tylko wtedy, gdy traktujesz ją jak asystenta, a nie autora. Automatyczne generowanie opisów według jednego szablonu, bez redakcji, prowadzi do dwóch problemów:

- wewnętrznej duplikacji – ten sam ton, te same frazy powtarzane na setkach kart,

- zewnętrznej duplikacji – inni korzystają z bardzo podobnych promptów i efektów.

Realnie korzystające z AI sklepy robią inaczej: generują szkic, a potem człowiek go dopracowuje, dodając kontekst, doświadczenie, konkrety z obsługi klienta. Dzięki temu treść spełnia standardy E‑E‑A‑T i brzmi jak głos konkretnej marki, a nie generatora.

Warianty produktów bez lawiny zduplikowanych podstron

Warianty to klasyczny ból głowy: kolor, rozmiar, pojemność, a czasem jeszcze zestawy. Jeśli każdy wariant żyje na osobnym URL z tym samym opisem, bardzo szybko kończysz z dziesiątkami klonów.

W praktyce bezpieczniejszy – i wygodniejszy dla klienta – jest model jednego produktu nadrzędnego z wariantami. Jeden URL, jeden główny opis, a różnice wariantów w:

- parametrach (kolor, rozmiar, pojemność),

- tabelach rozmiarów,

- specyfikacji technicznej konkretnego wariantu.

Kiedyś klient pokazał mi sklep z odzieżą, w którym ten sam T‑shirt w 12 kolorach miał 12 kart produktu z identycznym opisem. Po scaleniu tego w jedną kartę z wariantami, ruch na tym produkcie wzrósł, a użytkownicy przestali krążyć między podobnymi stronami, szukając „tego samego, ale w innym kolorze”.

Druga sprawa to obecność produktu w kilku kategoriach. Ten sam model sensownie pasuje np. do „buty do biegania”, „buty męskie” i „outlet”. Z punktu widzenia SEO kluczowe jest, by produkt miał jeden kanoniczny adres, nawet jeśli da się do niego dojść kilkoma ścieżkami menu. Większość platform e‑commerce technicznie to ogarnia – trzeba tylko sprawdzić ustawienia.

Aby uniknąć kanibalizacji, dobrze jest też ustalić prostą zasadę: kategorie odpowiadają na ogólne pytania i pomagają zawęzić wybór, a karty produktów schodzą w szczegóły konkretnego modelu. Wtedy Google ma jasny sygnał, która podstrona jest odpowiedzią na jaki typ zapytania.

Struktura URL, filtry i wyniki wyszukiwania – czyli gdzie robi się największy bałagan

Najbardziej niebezpieczne duplikaty zwykle nie powstają tam, gdzie spodziewa się tego właściciel sklepu. Tylko w filtrach i parametrach.

Widziałem sklep z elektroniką, gdzie kombinacje filtrów (marka, cena, przekątna ekranu, typ matrycy, klasa energetyczna) generowały miliony URL. Część z nich Google zdążył już zaindeksować. Ruchu z tego nie było prawie wcale, ale crawl budget zjadało znakomicie.

W praktyce trzeba podjąć kilka decyzji:

-

Jak ma wyglądać główna, kanoniczna ścieżka do kategorii i produktu.

Im prostsza i płytsza struktura, tym lepiej – zarówno dla użytkownika, jak i dla robotów. -

Które kombinacje filtrów są realnie wartościowe dla SEO.

Np. „buty trekkingowe damskie” ma sens jako osobna strona, ale „buty trekkingowe damskie filtr: sortuj po cenie rosnąco” już nie. -

Co robisz z parametrami, które tylko zmieniają widok (sortowanie, liczba produktów na stronie, widok listy/kafli) – najczęściej powinny być:

- wyłączone z indeksacji,

- albo wskazywać canonical na główny adres kategorii.

Paginacja to podobna historia. Sam fakt, że masz stronę 2, 3, 4 kategorii nie jest problemem, ale:

- pełny opis kategorii ma sens na pierwszej stronie,

- kolejne strony często warto „uspokoić” treściowo i/lub wskazać canonical na stronę 1, jeśli nie wnoszą nic świeżego.

⚠ UWAGA:

Wewnętrzna wyszukiwarka sklepu prawie nigdy nie jest treścią dla Google. Jej strony generują losowe, powtarzalne kombinacje zapytań i produktów. Indeksowanie ich zazwyczaj tylko szkodzi – warto trzymać je konsekwentnie w noindex.

Canonical: jak powiedzieć Google’owi „to jest główna wersja”

Rel="canonical" to jeden z tych tagów, które na papierze wyglądają banalnie, a w praktyce potrafią zrobić albo ogromne porządki, albo wielki bałagan.

Działa jako sugestia: „Drogi Google, jeśli widzisz kilka podobnych stron, tę traktuj jako główną”. Stosujemy go m.in. wtedy, gdy:

- ta sama kategoria ma wersje z parametrami (filtry, sortowanie),

- każdy wariant produktu ma własny URL, ale opis jest w dużej części powielony,

- paginacja de facto pokazuje ten sam asortyment, tylko podzielony na kilka podstron.

Dobrą praktyką jest też tzw. self‑canonical, czyli ustawienie canonicala na samą siebie na wszystkich kluczowych stronach: kategoriach, ważnych produktach, stronach informacyjnych. To zabezpiecza przed sytuacją, w której ten sam adres jest dostępny np. z różnymi parametrami albo z ukośnikiem / bez.

Najgorsze, co można zrobić, to:

- ustawić canonical na nieistniejący adres lub złą wersję językową,

- łączyć canonical z noindex na tej samej stronie (wyszukiwarka dostaje sprzeczne komunikaty),

- masowo wskazać canonicale między sobą na stronach, które wcale nie są duplikatami.

Zdarzyło mi się widzieć sklep, który przez błędną konfigurację canonicali „wyłączył” z wyników wszystkie strony kategorii, bo wskazywały canonical na jedną, techniczną stronę. Ruch spadł o połowę w kilka tygodni.

Przekierowania 301, noindex i robots.txt – sprzątanie technicznego chaosu

Jeśli canonical mówi „ta strona jest główna”, to 301 mówi „tej strony już nie ma, idź tu”. W e‑commerce przekierowania 301 przydają się przede wszystkim do:

- scalenia wersji http/https i www/bez www w jedną, docelową wersję,

- ujednolicenia wersji z ukośnikiem na końcu URL lub bez,

- obsługi wycofanych produktów (przekierowanie na nowszy model, najbliższą kategorię itp.).

Meta robots noindex z kolei jest jak znak „nie indeksuj tego”. Używa się go na stronach, które:

- nie mają wartości SEO (koszyk, checkout, konto użytkownika, drukuj, logowanie),

- są wewnętrznymi wynikami wyszukiwania,

- są mało wartościowymi kombinacjami filtrów, które nie mają sensu jako osobne wyniki w Google.

Robots.txt działa jeszcze poziom wyżej – mówi robotom, których katalogów czy parametrów w ogóle nie crawlujemy. To dobre narzędzie do:

- odcięcia nadmiarowych parametrów URL,

- ograniczenia dostępu do katalogów technicznych,

- ochrony fragmentów serwisu, które nie powinny być widoczne publicznie.

Ale tu łatwo o przesadę. Zablokowanie w robots.txt zasobów, których Google potrzebuje do zrozumienia strony (np. CSS, JS, kluczowe katalogi), może więcej zepsuć niż naprawić. Dlatego decyzje o blokadach najlepiej podejmować na danych: analizie logów serwera i raportach z narzędzi.

⚡ PRO TIP:

Ustal jedną, docelową wersję domeny (np. https, bez www) i wpisz ją wszędzie: w przekierowaniach, canonicalach, mapach strony, ustawieniach GSC. Mieszanie kilku wariantów to prosta droga do rozmycia sygnałów rankingowych.

Jak wykrywać duplikację: audyt, którego nie warto odkładać

Pierwszy „poważny” audyt duplikacji często jest bolesny – bo nagle widać, jak duża część serwisu to kopie. Ale lepiej zobaczyć to raz, niż miesiącami zgadywać, czemu SEO nie idzie.

Zazwyczaj łączę trzy źródła:

-

Crawler (Screaming Frog, Sitebulb, DeepCrawl).

Pokazuje zduplikowane tytuły, opisy, fragmenty treści, identyczne URL pod różnymi ścieżkami, powielone opisy w wariantach produktów, niekontrolowane parametry. W średnich sklepach 10–30% URL z oznaczeniem „duplicate” to nic niezwykłego. -

Checker zewnętrznej duplikacji (Copyscape, Siteliner, inne narzędzia antyplagiatowe).

Sprawdza, gdzie w sieci występuje ten sam tekst. Widać wtedy, które opisy producenta są już skopiowane w dziesiątkach sklepów albo kto skopiował Twoje treści 1:1. -

Google Search Console.

Tu widać, jak Google realnie widzi serwis: ile stron jest w indeksie, ile zostało wykluczonych jako duplikaty, jakie adresy kanoniczne Google wybiera samodzielnie. Raporty dotyczące kanonicznych adresów i wykluczonych URL często są najlepszym „alarmem”, że struktura wymaga porządków.

W praktyce dobrym rytmem jest audyt co 6–12 miesięcy plus dodatkowo po większych zmianach: migracji platformy, przebudowie drzewka kategorii, wdrożeniu nowych filtrów. Lepiej złapać problem na etapie kilkuset URL, niż czekać, aż zrobi się z tego kilkadziesiąt tysięcy.

Minimalny plan wdrożenia: od chaosu do kontroli

Kiedy wchodzę do projektu, w którym duplikacja już „wybuchła”, zwykle układam prosty plan, który można realizować etapami, bez wywracania całego sklepu.

-

Audyt duplikacji + priorytety biznesowe

Najpierw identyfikujemy największe źródła duplikacji (kategorie, filtry, warianty, blog), a potem patrzymy na to przez pryzmat pieniędzy: które sekcje generują najwięcej przychodu i powinny być posprzątane jako pierwsze. -

Jedna kanoniczna wersja domeny + przekierowania 301

Ustalamy, który wariant domeny jest „tym właściwym” i wymuszamy go przekierowaniami. To podstawa – bez tego reszta zmian ma ograniczony efekt. -

Canonicale i polityka indeksowania

Dla powielonych treści (kombinacje filtrów, warianty, paginacja) ustawiamy canonicale na główne wersje. Równolegle ustalamy zasady: co idzie w noindex, co blokujemy w robots.txt, co ma być indeksowane pełną parą. -

Strategia treści oparta na intencji

Dzielimy typy stron: co jest od „złapania ruchu” (kategorie, poradniki), co od domknięcia sprzedaży (produkty). Definiujemy, które opisy muszą być unikalne, jak mają wyglądać, jakie pytania klienta mają obsłużyć. -

Wdrożenie w CMS + procesy zespołu

Ustawiamy technikalia w panelu (canonical, noindex, struktura URL), a zespołowi contentowemu dajemy jasne wytyczne: czego nie kopiujemy, jak oznaczamy warianty, kto decyduje o scalaniu podobnych treści. -

Monitoring i korekty

Po kilku tygodniach zaglądamy do GSC: jak zmienia się liczba indeksowanych stron, które adresy Google wyklucza, jak reaguje ruch. Co 6–12 miesięcy robimy powtórny audyt, bo każdy nowy filtr, nowa kategoria czy integracja może dorzucić nową porcję duplikatów.

Najczęstsze pytania o duplikację treści w sklepach online

Na koniec kilka pytań, które regularnie słyszę przy wdrożeniach.

Czym dokładnie jest duplikacja treści w sklepie internetowym?

To powielanie tych samych lub bardzo podobnych tekstów – opisów produktów, kategorii, meta tagów, a także treści blogowych – w wielu miejscach sklepu lub na różnych domenach. Google ma wtedy problem z ustaleniem, która wersja jest „tą właściwą”, a resztę filtruje.

Czy za duplikację treści można dostać karę od Google?

Typowa kara ręczna zdarza się rzadko i zwykle tylko wtedy, gdy Google widzi próbę manipulacji. W większości przypadków algorytmy po prostu wykluczają duplikaty z wyników, wybierając jedną wersję jako kanoniczną. W praktyce skutki – spadek widoczności i ruchu – są odczuwalne tak samo.

Czy zmiana samego meta title i description usuwa problem duplicate content?

Nie. Meta tagi to tylko „etykieta” strony w wynikach. Dla oceny duplikacji liczy się głównie główna treść – opis kategorii, treść artykułu, opis produktu. Jeśli te są takie same, kosmetyka w meta tagach niczego nie załatwia.

Czy mogę używać opisów producenta?

Możesz, ale to zawsze oznacza wysokie ryzyko zewnętrznej duplikacji. Ten sam tekst ma zwykle wielu sprzedawców, więc Twój sklep nie ma żadnej przewagi. Najrozsądniej traktować opisy producenta jako punkt startowy i rozbudowywać je o własne doświadczenia, porównania, FAQ, zdjęcia, case’y z obsługi klienta.

Czy różne wersje językowe to duplikacja?

Jeśli mają osobne URL i poprawnie wdrożone hreflang, Google rozumie je jako odpowiedniki na inne rynki, a nie jako duplikaty. Problem pojawia się dopiero wtedy, gdy np. polska i angielska wersja żyją pod tym samym adresem lub hreflang jest pomieszany.

Czy blog może szkodzić SEO sklepu przez duplikację?

Tak, jeśli generuje dużą liczbę bardzo podobnych wpisów o tym samym. Z czasem kilka tekstów zaczyna rywalizować o identyczne frazy. Często lepiej połączyć podobne artykuły w jeden, porządnie dopracowany poradnik niż trzymać pięć słabych wersji.

Jak rozpoznać, że marnuję crawl budget przez duplikację?

Sygnały to m.in.:

- dużo podobnych, mało wartościowych URL w indeksie,

- raporty w GSC o zduplikowanych stronach i własnych kanonicznych Google’a,

- ciągłe problemy z szybkim indeksowaniem nowych produktów.

Najczęściej winne są paginacja, filtry, parametry i brak kontroli nad tym, co faktycznie jest indeksowane.

Jak traktować paginację i warianty produktów, żeby uniknąć duplicate content?

Potrzebna jest przemyślana struktura URL i jasna rola canonicali. Warianty najlepiej spiąć w jedną kartę produktu lub wyraźnie wskazać główny wariant canonicalem. Paginację warto ograniczyć treściowo i – jeśli to ma sens – kanonizować do pierwszej strony kategorii. Dzięki temu Google skupia się na tym, co dla Ciebie naprawdę sprzedaje.

Duplikacja treści rzadko zabija sklep jednego dnia. Bardziej przypomina mały, ale stały wyciek w zbiorniku z ruchem. Im szybciej go uszczelnisz – technicznie i treściowo – tym więcej z tego ruchu zostanie u Ciebie, zamiast rozlewać się po kopiach Twoich własnych stron.